رحلة داخل عقل الذكاء الاصطناعي: فك شفرة آلية عمل الشبكات العصبية

اكتشف تطورها وأهم تطبيقاتها في الطب، التجارة، والسيارات الذاتية

مقدمة

هل فكرت يومًا كيف يمكن لهاتفك الذكي التعرّف على أصدقائك في الصور تلقائيًا؟ أو كيف يتمكّن مساعد افتراضي مثل Alexa من فهم أوامرك الصوتية بدقة مذهلة؟

وراء هذه القدرات المذهلة تكمن تقنية أساسية تُعرف باسم الشبكات العصبية في الذكاء الاصطناعي، وهي نماذج حوسبية مستوحاة من طريقة عمل الدماغ البشري، وتمكّن الأنظمة من التعلم من البيانات وتحسين أدائها باستمرار، مما يجعلها جزءًا أساسيًا من تطبيقات الذكاء الاصطناعي المتقدمة مثل معالجة اللغة الطبيعية والتعرف على الصور.

أهمية الشبكات العصبية

تلعب الشبكات العصبية دورًا حاسمًا في تطوير أنظمة ذكية قادرة على التعلم من البيانات الضخمة وتحليل الأنماط المعقدة، معتمدة على بناء نماذج متعددة الطبقات لمعالجة البيانات وتحليلها بطرق تشبه عملية التعلم لدى الإنسان.

وأصبحت هذه القدرة بفضل وجود هذه الشبكات جزءًا لا غنى عنه في تقنيات مثل التعلم العميق، مما مكن الذكاء الاصطناعي من تحقيق تقدم غير مسبوق في مجالات متعددة مثل الطب والصناعة والتجارة الإلكترونية.

كيف بدأت؟

بدأ مفهوم الشبكات العصبية في أوائل الأربعينيات من القرن العشرين عندما قدم العالمان “Warren McCulloch” و”Walter Pitts” نموذجًا رياضيًا بسيطًا لمحاكاة كيفية عمل الخلايا العصبية في الدماغ البشري. لاحقًا، في عام 1958، قدم “فرانك روزنبلات” نموذج Perceptron، والذي يُعتبر أول تطبيق عملي للشبكات العصبية.

ومع ذلك، شهد المجال ركودًا في السبعينيات والثمانينيات بسبب ما يُعرف بـ”الشتاء الأول للذكاء الاصطناعي”، حيث واجه الباحثون تحديات مثل ضعف القدرات الحاسوبية وصعوبة تدريب الشبكات. في التسعينيات، عاد الاهتمام بفضل التطورات في الخوارزميات مثل الانحدار الخلفي (Backpropagation) ومعالجات الحواسيب الأسرع.

في الألفية الجديدة، ارتبط النمو الكبير في هذا المجال بظهور تقنيات التعلم العميق (Deep Learning)، حيث تم تحسين الشبكات العصبية العميقة (DNN) بفضل التقدم في وحدات معالجة الرسوميات (GPUs) ووجود بيانات ضخمة.

أهم العلماء والأبحاث المؤثرة

- جيفري هينتون:

- يُعتبر الأب الروحي للتعلم العميق.

- قدم أبحاثًا عن الشبكات العصبية التلافيفية (CNN) وتدريب الشبكات العميقة.

- يان ليكون:

- طور شبكة LeNet الشهيرة لمعالجة الصور.

- أحد رواد تطبيقات الشبكات العصبية في الرؤية الحاسوبية.

- جوشوا بينجيو:

- ساهم في تطوير خوارزميات التعلم غير الخاضع للإشراف.

- أندرو نج:

- قاد مشروع Google Brain وأدخل الشبكات العصبية في تقنيات حديثة مثل التعرف على الصوت.

- قاد مشروع Google Brain وأدخل الشبكات العصبية في تقنيات حديثة مثل التعرف على الصوت.

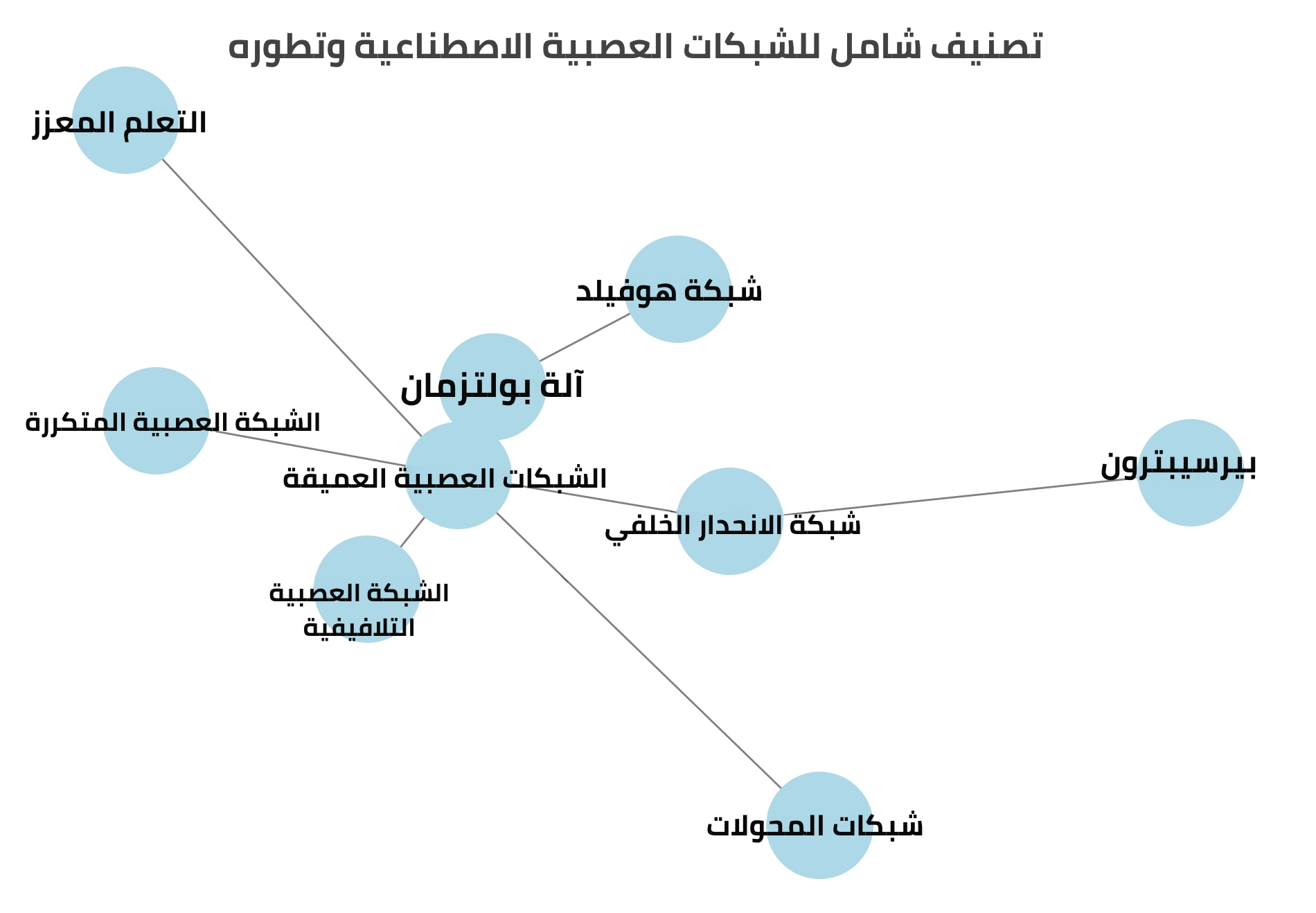

مراحل تطورها

مع تطور الشبكات العصبية على مدار العقود، مرت بعدة مراحل أساسية أدت إلى تحسين بنيتها وأدائها. فيما يلي نستعرض المراحل الأبرز التي شكّلت هذا المجال:

1. المرحلة الأولى: البداية مع Perceptron

في عام 1958، قدم العالم فرانك روزنبلات مفهوم Perceptron، وهو أول نموذج حاسوبي بسيط للشبكات العصبية الاصطناعية. كانت الفكرة قائمة على محاكاة الخلايا العصبية في الدماغ البشري من خلال إنشاء نظام حوسبي يستطيع التعلم من خلال تعديل الأوزان بناءً على المدخلات والمخرجات. وعلى الرغم من محدوديته وعدم قدرته على حل المشاكل غير الخطية، إلا أنه كان حجر الأساس في تطويرها.

2. المرحلة الثانية: ظهور Backpropagation

في الثمانينيات، أُعيد إحياء الاهتمام بالشبكات العصبية بفضل خوارزمية الانحدار الخلفي (Backpropagation) التي طورها جيفري هينتون وزملاؤه. وساهمت الخوارزمية في تمكين تدريب الشبكات متعددة الطبقات (Multilayer Perceptrons – MLP). وتعتمد على تقليل الخطأ بين النتائج المتوقعة والفعلية من خلال تعديل الأوزان بشكل تدريجي. وكانت هذه التقنية نقطة التحول في تطويرها، حيث جعلت التدريب أكثر كفاءة ودقة.

3. المرحلة الثالثة: الشبكات التلافيفية (Convolutional Neural Networks – CNNs)

في التسعينيات، قدم العالم يان ليكون مفهوم الشبكات العصبية التلافيفية (CNNs)، والتي تم تصميمها لمعالجة الصور. وتعتمد على استخدام طبقات تلافيفية لتحليل الأنماط والسمات البصرية في الصور، مما أدى إلى تحسين كبير في مهام مثل التعرف على الصور وتصنيفها. وتُستخدم CNNs اليوم في تطبيقات مثل التعرف على الوجوه، تشخيص الأمراض من صور الأشعة، والقيادة الذاتية.

4. المرحلة الرابعة: الشبكات المتكررة (Recurrent Neural Networks – RNNs)

مع الحاجة إلى التعامل مع البيانات الزمنية، ظهرت الشبكات العصبية المتكررة (RNNs) التي تعتمد على حفظ المعلومات السابقة من خلال استخدام آلية التغذية الراجعة. وتُستخدم RNNs بشكل رئيسي في معالجة اللغة الطبيعية (NLP)، والترجمة الآلية، وتحليل النصوص. ومع ذلك واجهت تحديات مثل مشكلة التلاشي التدريجي للذاكرة (Vanishing Gradient Problem)، مما دفع إلى تطوير نماذج محسنة مثل LSTM وGRU.

5. المرحلة الخامسة: الشبكات العصبية العميقة (Deep Neural Networks – DNNs)

مع توفر كميات هائلة من البيانات وتحسن القدرات الحاسوبية مثل استخدام وحدات معالجة الرسومات (GPUs)، ظهرت الشبكات العصبية العميقة (DNNs). وتُعتبر تطورًا للشبكات متعددة الطبقات، لكنها تتميز بوجود طبقات مخفية أكثر، مما يجعلها قادرة على معالجة بيانات معقدة جدًا مثل النصوص والصور والفيديوهات.

6. المرحلة السادسة: شبكات المحولات (Transformer Networks)

في عام 2017، أحدثت ورقة بحثية من Google تحولًا كبيرًا من خلال تقديم نموذج Transformer. وتعتمد هذه الشبكات على آلية الانتباه (Attention Mechanism) لمعالجة اللغة بشكل أكثر كفاءة. وتُعتبر العمود الفقري لتطبيقات مثل ChatGPT وBERT، مما يجعلها قادرة على فهم اللغة الطبيعية بدقة مذهلة.

7. المرحلة السابعة: التعلم المعزز (Reinforcement Learning)

التعلم المعزز ليس شبكة عصبية بحد ذاته، لكنه تقنية تُستخدم لتدريبها على اتخاذ القرارات بناءً على المكافآت والعقوبات. وتُستخدم هذه التقنية في مجالات مثل الألعاب (مثل AlphaGo)، والروبوتات، والسيارات ذاتية القيادة. وعندما يتم دمج التعلم المعزز مع الشبكات العصبية العميقة، يتم تطوير أنظمة ذكية قادرة على التكيف مع البيئات المختلفة.

أهم العوامل التي ساهمت في تطورها

- توفر البيانات الضخمة:

ساهم النمو الهائل في البيانات المتاحة عبر الإنترنت في تدريب نماذج أكثر دقة. - التقدم في العتاد الحاسوبي:

وحدات معالجة الرسوميات (GPUs) جعلت التدريب عليها. - تحسين الخوارزميات:

خوارزميات مثل Backpropagation وAdam ساعدت في تقليل الأخطاء وتحسين الأداء.

أهم التحديات

مثل أي تقنية متقدمة، تواجه الشبكات العصبية في الذكاء الاصطناعي تحديات تحتاج إلى حلول مبتكرة، من أبرزها:

- الاعتماد الكبير على البيانات: حيث تتطلب كميات ضخمة من البيانات لتقديم نتائج دقيقة.

- متطلبات الحوسبة العالية: بسبب حاجة الشبكات إلى أجهزة حاسوب ذات قدرات عالية لمعالجة البيانات بفعالية، مما يزيد من التكاليف.

- صعوبة التفسير: من الصعب أحيانًا فهم كيفية اتخاذ القرارات، مما يثير مخاوف حول الشفافية والمسؤولية.

استراتيجيات تحسين أدائها في الذكاء الاصطناعي

تُعتمد العديد من الاستراتيجيات لتحسين فعالية الشبكات العصبية في الذكاء الاصطناعي وتقليل التحديات المرتبطة بها، مثل:

- تحسين بنية الشبكة: يمكن استخدام شبكات عميقة متعددة الطبقات لتحليل بيانات أكثر تعقيدًا.

- استخدام التعلم المُعزز: تمكّن هذه التقنية من تحسين أدائها بناءً على المكافآت والعقوبات.

- التدريب الموزع: يمكن تقسيم تدريب النماذج عبر عدة أجهزة لتقليل الوقت والتكاليف.

كيفية عمل الشبكات العصبية في الذكاء الاصطناعي

الوحدات العصبية (Neurons):

تُعرف أيضًا باسم الخلايا العصبية الاصطناعية، وهي وحدات صغيرة تقوم بمعالجة البيانات. كل خلية عصبية تتلقى إشارات (مدخلات) من الخلايا العصبية الأخرى أو من البيانات الخام، وتعالج هذه الإشارات، ثم تمرر النتيجة إلى الخلايا العصبية التالية.

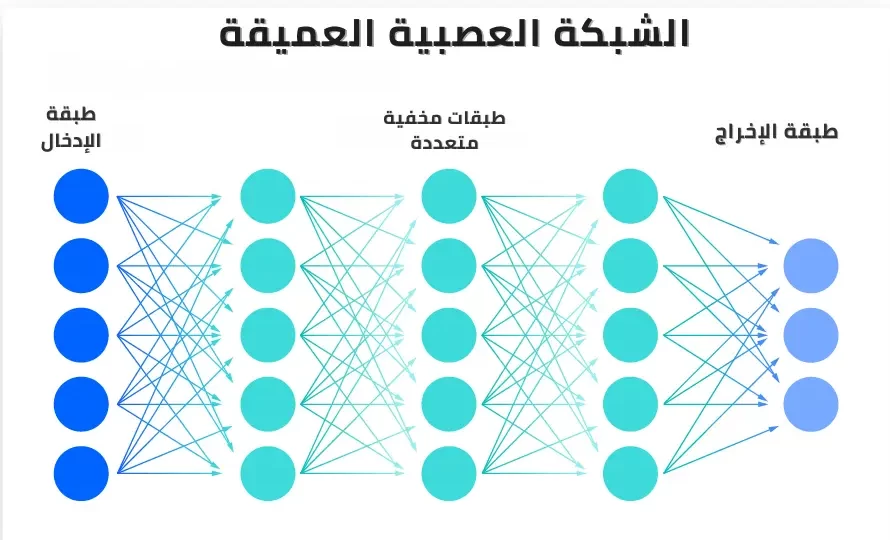

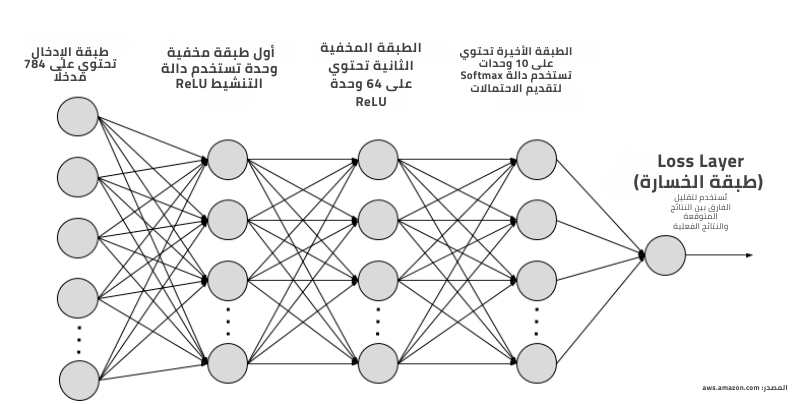

الطبقات (Layers):

تتكون الشبكات العصبية في الذكاء الاصطناعي من طبقات متعددة. كل طبقة تحتوي على مجموعة من الخلايا العصبية. هناك ثلاثة أنواع أساسية من الطبقات:

- طبقة الإدخال (Input Layer): تستقبل المدخلات الخام من البيانات.

- الطبقات المخفية (Hidden Layers): تقوم بمعالجة البيانات وتحليلها.

- طبقة الإخراج (Output Layer): تعطي النتائج النهائية بعد معالجة البيانات.

الأوزان والانحياز:

- الأوزان (Weights): تحدد قوة الاتصال بين كل خليتين عصبيتين.

- الانحياز (Bias): هو قيمة ثابتة تُضاف إلى مخرجات الخلايا العصبية للمساعدة في ضبط النتيجة النهائية.

دالة التنشيط (Activation Function):

هي دالة تُستخدم لتحويل المخرجات الخام للخلايا العصبية إلى قيمة قابلة للاستخدام في الطبقات اللاحقة. تُقدم دالة التنشيط اللاخطية، مما يجعل الشبكات العصبية قادرة على تعلم الأنماط المعقدة.

أهم المفاهيم

1. الانحدار الخلفي (Backpropagation):

هي خوارزمية تُستخدم لتحديث الأوزان في الشبكات العصبية في الذكاء الاصطناعي بناءً على الفرق بين القيم المتوقعة والفعلية. تُستخدم هذه التقنية لتقليل دالة الخسارة وتحسين دقة النموذج.

2. دالة الخسارة (Loss Function):

تُستخدم لقياس مدى جودة أداء النموذج. كلما كانت دالة الخسارة أصغر، كان أداء النموذج أفضل.

3. التحسين (Optimization):

عملية تعديل الأوزان والانحيازات في الشبكات العصبية في الذكاء الاصطناعي لتقليل دالة الخسارة. يتم ذلك باستخدام خوارزميات مثل انحدار الحدي الأدنى (Gradient Descent).

أمثلة تطبيقية

-

في الطب:

- تُستخدم الشبكات العصبية التلافيفية (CNN) في تحليل صور الأشعة للكشف عن السرطان بدقة عالية.

- تعتمد الشبكات العميقة على بيانات المرضى لتطوير خطط علاجية مخصصة.

-

في التجارة الإلكترونية:

- تساهم في توصية المنتجات بناءً على سلوك المستخدمين، مثل نظام التوصيات في Amazon.

-

- تُستخدم الشبكات العصبية التلافيفية لمعالجة الصور الملتقطة من الكاميرات وتحليل البيئة المحيطة، مما يساعد السيارة على اتخاذ قرارات فورية.

دراسات حالة (Case Studies)

-

كشف الاحتيال المصرفي:

- استخدمت بعض البنوك الشبكات العصبية المتكررة (RNN) لتحليل أنماط البيانات الزمنية لاكتشاف المعاملات غير الطبيعية.

- النتائج: تقليل معدل الاحتيال بنسبة تصل إلى 85%.

-

تشخيص الأمراض:

- دراسة أجرتها جامعة ستانفورد استخدمت الشبكات العصبية لتحليل صور الجلد وكشف سرطان الجلد.

- النتائج: أداء يعادل الأطباء ذوي الخبرة العالية.

ملخص

تُعد الشبكات العصبية في الذكاء الاصطناعي من الأدوات الأساسية التي مكّنت الأنظمة الذكية من تحليل البيانات بطرق شبيهة بالعقل البشري. ورغم التحديات التي تواجهها، إلا أن التطورات المستمرة تفتح أبوابًا جديدة للابتكار في مختلف القطاعات.

الأسئلة الشائعة

كيف أبدأ في تعلم الشبكات العصبية؟

-

- ابدأ بفهم الأساسيات من خلال دورات مجانية مثل “Introduction to Neural Networks” على منصات مثل Coursera وedX.

- جرب أطر العمل الشهيرة مثل TensorFlow وPyTorch.

ما هي أحدث الابتكارات في هذا المجال؟

-

-

- دمج الشبكات العصبية مع الذكاء الاصطناعي التوليدي (Generative AI) لتطوير تطبيقات مثل إنشاء الصور والنصوص.

- تطوير شبكات Transformer مثل ChatGPT التي تُستخدم في معالجة اللغة الطبيعية.

-

ما هي الشبكات العصبية في الذكاء الاصطناعي؟

- هي نماذج حسابية مستوحاة من الدماغ البشري، حيث تتكون من مجموعة من الوحدات العصبية (Neurons) المرتبطة ببعضها البعض. يتم استخدامها لتعلم الأنماط المعقدة في البيانات ولإجراء مهام مثل التصنيف والتنبؤ.

كيف تعمل؟

- تتكون من طبقات: طبقة إدخال تستقبل البيانات، طبقات مخفية لمعالجة البيانات، وطبقة إخراج تعطي النتيجة النهائية. الخلايا العصبية في كل طبقة متصلة بالخلايا العصبية في الطبقات الأخرى من خلال أوزان تحدد مدى تأثير كل خلية عصبية.

ما هي أنواعها؟

- الشبكات العصبية الاصطناعية (ANN): تُستخدم للتنبؤ والتصنيف.

- الشبكات العصبية التلافيفية (CNN): تُستخدم في الرؤية الحاسوبية مثل التعرف على الصور.

- الشبكات العصبية المتكررة (RNN): تُستخدم لتحليل البيانات المتسلسلة مثل النصوص.

- الشبكات العصبية العميقة (DNN): تحتوي على طبقات مخفية متعددة وتُستخدم في التطبيقات المتقدمة مثل التعرف على الصوت.

ما هو دور دالة التنشيط؟

- دالة التنشيط تُحوِّل الإشارات الصادرة من الخلايا العصبية إلى قيم يمكن استخدامها في الطبقات اللاحقة.

ما هو الانحدار الخلفي؟

- الانحدار الخلفي هو خوارزمية تُستخدم لتحديث الأوزان في الشبكة العصبية. تعتمد على حساب الفرق بين المخرجات المتوقعة والفعلية وتعديل الأوزان لتقليل هذا الفرق.

6. ما هي دالة الخسارة؟

- دالة الخسارة تقيس مدى جودة أداء النموذج. كلما كانت دالة الخسارة أصغر، كان أداء النموذج أفضل. من أشهر دوال الخسارة:

- MSE (Mean Squared Error): تُستخدم في التنبؤ بالقيم المستمرة.

- Cross-Entropy: تُستخدم في مشاكل التصنيف.

ما هي تحديات استخدامها؟

- التكلفة الحسابية العالية: تتطلب موارد كبيرة للتدريب، خاصة مع البيانات الضخمة.

- الحاجة إلى كميات كبيرة من البيانات: تحتاج إلى بيانات ضخمة لتعمل بفعالية.

- الإفراط في التكيف (Overfitting): قد تتعلم الأنماط غير المهمة إذا كانت الشبكة معقدة جدًا.

ما هي التطبيقات الشائعة للشبكات العصبية؟

-

- التعرف على الصور: تُستخدم الشبكة العصبية التلافيفية (CNN) في التعرف على الصور وتصنيفها.

- معالجة اللغة الطبيعية (NLP): تُستخدم الشبكة العصبية المتكررة (RNN) في الترجمة الآلية وتحليل النصوص.

- التعرف على الصوت: تُستخدم في تطوير أنظمة مثل المساعدات الصوتية.

شاهد أيضا: