DeepSeek-R1: البديل الصيني القوي لمواجهة ChatGPT

كل ما تحتاج معرفته عن DeepSeek-R1

DeepSeek-R1: منافس ChatGPT الصيني

في السنوات الأخيرة، برزت الصين كمنافس قوي في مجال الذكاء الاصطناعي، حيث نجحت شركاتها في تطوير نماذج متقدمة تنافس أشهر النماذج الأمريكية مثل ChatGPT و Claude. ومن بين هذه الشركات، تميزت DeepSeek بإطلاق نموذجها الجديد DeepSeek-R1، الذي جاء كتحسين وتطوير للنموذج السابق DeepSeek-V3، الذي حقق أداءً مبهرا في اختبارات متعددة وتفوق على العديد من النماذج الأخرى.

ما هو DeepSeek-R1؟

DeepSeek-R1 هو نموذج ذكاء اصطناعي مفتوح المصدر تم تطويره من قبل شركة DeepSeek الصينية، وهي شركة ناشئة بدأت كمشروع بحثي تابع لصندوق التحوط الكمي High-Flyer Capital Management. يتميز النموذج (الذي يعتبره البعض بأنه chat gpt الصيني أو بديل chatgpt) بقدرات متقدمة في معالجة اللغة الطبيعية والتفكير الاستنتاجي، مما يجعله مناسبًا لمهام مثل التحليل اللغوي المعقد والبرمجة وحل المشكلات الرياضية.

مميزات DeepSeek-R1 (بديل شات جي بي تي)

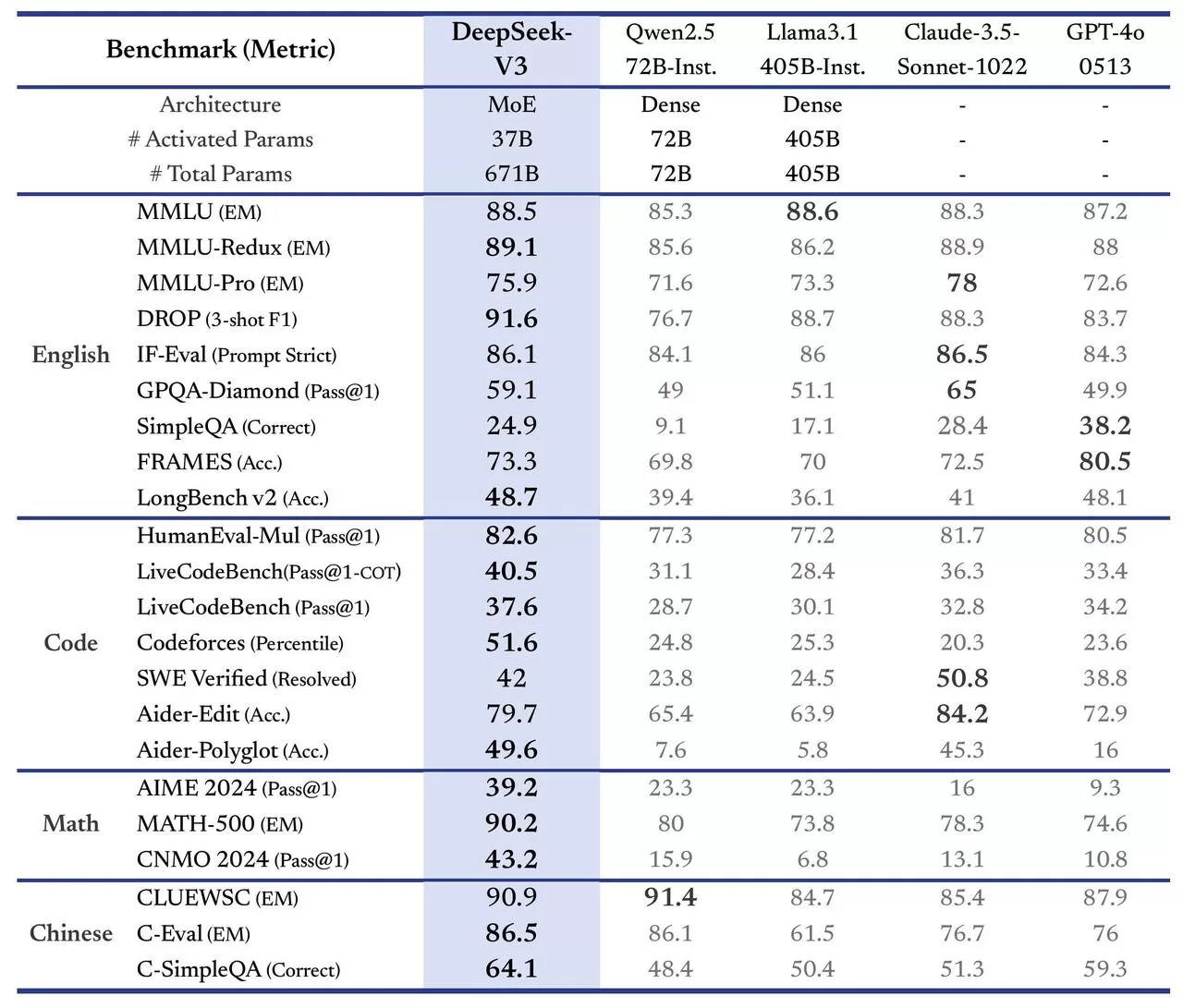

- كفاءة الأداء: سجل أداءً مميزًا في اختبارات الرياضيات مثل MATH-500 بنسبة 90.2%، وفي اختبارات البرمجة مثل HumanEval-Mul بنسبة 82.6%.

- تكلفة منخفضة: يتميز بكونه أقل تكلفة بنسبة تصل إلى 90% مقارنة بالنماذج الأمريكية مثل GPT-4، مع تكلفة تطوير تقارب 5.57 مليون دولار فقط.

- دعم اللغة الصينية: أظهر تفوقًا في اختبارات اللغة الصينية مثل CLUEWSC (90.9%) وC-Eval (86.5%).

- مرونة الاستخدام: يتاح للمستخدمين عبر منصة Hugging Face، ومن خلال واجهة برمجة التطبيقات (API) الخاصة به لتكامل أفضل مع التطبيقات المختلفة.

كيفية استخدام DeepSeek-R1

1. عبر واجهة المحادثة:

- زيارة الموقع الرسمي لشركة DeepSeek.

- تسجيل حساب جديد باستخدام البريد الإلكتروني.

- بدء المحادثة عبر الواجهة المخصصة مثل ChatGPT.

2. عبر API:

يمكنك دمج النموذج في تطبيقاتك باستخدام API عبر الطلبات التالية:

import requests

import json

url = "https://api.deepseek.com/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_API_KEY"

}

payload = {

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": False

}

response = requests.post(url, headers=headers, data=json.dumps(payload))

print(response.json())3. تشغيل النموذج محليًا عبر Hugging Face:

- استنساخ المستودع من GitHub.

- تثبيت المتطلبات باستخدام الأمر

pip install -r requirements.txt. - تحميل نقاط التفتيش من Hugging Face وتشغيل النموذج محليًا.

مقارنة DeepSeek-R1 مع النماذج الأخرى

أظهرت المقارنات الأولية أن DeepSeek-R1 يتفوق في مجالات الرياضيات والبرمجة واللغة الصينية، ولكنه لا يزال أقل من النماذج الأمريكية مثل GPT-4 وClaude في اختبارات الفهم اللغوي الإنجليزي.

يمكنك الاطلاع على التقرير الكامل للمقارنة بين بديل chatgpt والنماذج الأخرى عبر هذا الرابط.

الانتقادات والمخاوف

رغم نجاح DeepSeek-R1، إلا أن هناك مخاوف من أنه يعتمد جزئيًا على مخرجات GPT-4 في تدريبه، مما يثير تساؤلات حول أصالة النموذج وخطر تعزيز التحيزات الموجودة.

5 أسباب تجيب عن سؤال: كيف تفوق DeepSeek الصيني على النماذج الأمريكية؟

الأسئلة الشائعة (FAQ)

ما هو نموذج DeepSeek-R1؟

هو نموذج ذكاء اصطناعي مفتوح المصدر تم تطويره من قبل شركة DeepSeek الصينية، يتميز بقدراته في معالجة اللغة الطبيعية والبرمجة وحل المشكلات الرياضية. يعتبره البعض بأنه chat gpt الصيني أو بديل chatgpt

ما هي أهم مميزات DeepSeek-R1؟

كفاءة عالية في اختبارات الرياضيات والبرمجة.

تكلفة منخفضة بنسبة تصل إلى 90% مقارنة بالنماذج الأمريكية.

دعم ممتاز للغة الصينية.

مرونة الاستخدام عبر منصات متعددة مثل Hugging Face وواجهات برمجة التطبيقات (API).

كيف يمكن استخدام DeepSeek-R1؟

يتوفر DeepSeek-R1 عبر منصة Hugging Face، أو تحميل تطبيق deepseek في كل من iOs، وأندرويد، كما يمكن تحربته من خلال DeepSeek Chat أو استخدام واجهة البرمجة (API) للأغراض التجارية بأسعار تنافسية.

ما هي الانتقادات الموجهة لـ DeepSeek-R1؟

هناك مخاوف من استخدام مخرجات GPT-4 في تدريبه، مما قد يعزز التحيزات الموجودة.

كيف يقارن DeepSeek-R1 مع النماذج الأخرى؟

أظهر تفوقًا في الرياضيات والبرمجة واللغة الصينية، لكنه لا يزال دون مستوى بعض النماذج الأمريكية مثل GPT-4 في فهم اللغة الإنجليزية.

هل يمكن استخدام DeepSeek-R1 للأغراض التجارية؟

نعم، يمكن دمجه في التطبيقات عبر API ويُتاح أيضًا كمصدر مفتوح للمطورين.

ما هي تكلفة استخدام DeepSeek-R1؟

يتوفر DeepSeek-R1 مجانًا للأغراض الشخصية، مع خطط تجارية للاستخدامات المتقدمة.